Fast kein Tag vergeht, an dem man nicht mit dem Thema „Künstliche Intelligenz“ in Form des Textautomaten ChatGPT (GPT bedeutet „generative pre-trained transformer“ – 2018 erschien GPT-1, GPT-2 in 2019, GPT-3 im Mai 2020, inzwischen – März 2023 – wird GPT-4 eingesetzt) konfrontiert wird. Auch Google Trends zeigt seit letzten Dezember einen deutlichen Anstieg bei den Suchen nach dem Stichwort „ChatGPT“. Journalistenanfragen kommen nun häufiger bei mir an. Der Wettlauf zwischen OpenAI/Microsoft (und Elon Musk) und Bard/Google ist in vollem Gange.

In diesem Beitrag frage ich mich, was ChatGPT kann und was nicht. Ich habe mir ein paar Test-Aufgaben ausgedacht, um die Leistungsfähigkeit von ChatGPT im Ansatz zu prüfen. Eine gute Schreibung von ChatGPT liefert Stephen Wolfram, der Erfinder von „Mathematica“ , in seinem 2023 erschienenen open-access-Buch „What is ChatGPT doing … and why does it work?“ (hier erhältlich).

Als erstes will ich einmal die historische Kompetenz prüfen, dazu blicke ich in die Geschichte unseres Heidelberger Psychologischen Instituts.

Prompt JF an https://chat.openai.com/: „Was kannst du mir über das Psychologische Institut der Universität Heidelberg sagen?“ Antwort von ChatGPT: „Das Psychologische Institut der Universität Heidelberg ist eines der ältesten und renommiertesten psychologischen Institute in Deutschland. Es wurde im Jahr 1879 gegründet und ist Teil der Fakultät für Verhaltens- und Empirische Kulturwissenschaften.

Das Institut bietet eine breite Palette von Studiengängen und Forschungsmöglichkeiten in verschiedenen Bereichen der Psychologie, wie z.B. Klinische Psychologie, Sozialpsychologie, Entwicklungspsychologie, Kognitionspsychologie und Neuropsychologie. Es gibt auch verschiedene Forschungseinrichtungen und Zentren am Institut, die sich mit spezifischen Themen wie Arbeits- und Organisationspsychologie, Kognitive Neurowissenschaften und Gesundheitspsychologie beschäftigen.

Das Psychologische Institut der Universität Heidelberg hat einen exzellenten Ruf in der akademischen Welt und ist bekannt für seine innovativen Forschungsprojekte und seine international anerkannten Forscher. Darüber hinaus bietet das Institut eine hervorragende Ausbildung für Studierende, die sich für eine Karriere in der Psychologie interessieren.“

Was ich hier zu lesen bekomme, ist gar nicht mal schlecht – weil es so schmeichelhaft klingt? Leider ist ein fundamentaler Fehler enthalten: das genannte Gründungsjahr 1879 ist das Jahr der Gründung des weltweit ersten psychologischen Instituts in Leipzig durch Wilhelm Wundt. Leider NICHT in Heidelberg! Auch wenn Wundt Heidelberger Wurzeln trägt. Ein kleiner, aber nicht unwichtiger Fehler, der nur kenntnisreichen Leser:innen auffällt. Genauso falsch: „Das Institut bietet eine breite Palette von Studiengängen“: wir bieten genau einen Studiengang (mit Bachelor- und Master-Option).

Schauen wir doch mal, was ChatGPT über eine andere mir bekannte Universität zu berichten weiß.

Prompt: „Was kannst du mir über das Psychologische Institut der Universität Trier sagen?“ ChatGPT: „Das Psychologische Institut der Universität Trier ist eines der führenden psychologischen Forschungs- und Ausbildungsinstitute in Deutschland. Es wurde im Jahr 1975 gegründet und ist Teil der Fakultät für Psychologie.

Das Institut bietet eine breite Palette von Studiengängen und Forschungsmöglichkeiten in verschiedenen Bereichen der Psychologie, wie z.B. Klinische Psychologie, Pädagogische Psychologie, Arbeits- und Organisationspsychologie, Sozialpsychologie und Entwicklungspsychologie. Es gibt auch verschiedene Forschungseinrichtungen und Zentren am Institut, die sich mit spezifischen Themen wie Emotionsforschung, Stressforschung und Verhaltensneurobiologie beschäftigen.

Das Psychologische Institut der Universität Trier hat einen exzellenten Ruf in der akademischen Welt und ist bekannt für seine innovativen Forschungsprojekte und seine international anerkannten Forscher. Darüber hinaus bietet das Institut eine hervorragende Ausbildung für Studierende, die sich für eine Karriere in der Psychologie interessieren. Besonders hervorzuheben ist die Forschungsexzellenz des Instituts, die in verschiedenen Rankings und Bewertungen immer wieder bestätigt wird.“

Was bei diesem zweiten Beispiel auffällt, ist die große Parallelität in den Formulierungen zwischen den Instituten in Heidelberg und Trier. Bestimmte Floskeln, die sich angenehm lesen, werden wieder verwendet. Damit schwindet der Mythos der Einzigartigkeit dahin, das Floskelhafte wird erkennbar. Falsch ist hier die Angabe „ist Teil der Fakultät für Psychologie“ – das Fach ist dem Fachbereich I zugeordnet, eine „Fakultät für Psychologie“ gibt es dort nicht. Auch die „breite Palette von Studiengängen“ stimmt mal wieder nicht. Genauere Angaben finden sich übrigens auf der Homepage des Trierer Instituts.

Schließlich muss ich ChatGPT nach einem „guten“ Psychologenwitz fragen – schlechte gibt es genug. Hier das Ergebnis:

Prompt: „Erzähle mir einen guten Psychologenwitz.“ ChatGPT: „Natürlich! Hier ist ein Psychologenwitz:

Ein Mann geht zu einem Psychologen und sagt: „Ich fühle mich oft wie ein Hund. Ich laufe auf allen Vieren herum und belle manchmal sogar.“ Der Psychologe fragt: „Seit wann fühlen Sie sich so?“ Der Mann antwortet: „Seit ich ein Welpe war.“

Bitte beachten Sie, dass dies nur ein Witz ist und keine psychologischen Störungen oder Probleme herunterspielen soll. Psychische Gesundheit ist ein ernstes Thema und sollte mit Respekt und Sorgfalt behandelt werden.“

Der ist nicht grottenschlecht, aber auch nicht umwerfend! Von einem guten Witz würde ich hier nicht sprechen. Und natürlich die Witz-Warnung am Ende: köstlich! Darüber kann ich fast noch mehr lachen… Sehr amerikanisch!

Natürlich gibt es weitere Aspekte, die den Einsatz des Text-generierenden Automaten problematisch erscheinen lassen. Vor allem Schriftsteller, die Texte produzieren, fühlen sich benachteiligt, wenn ihre Texte als Trainingsdaten dienen, aber nicht honoriert werden (vergütungsfreies Data-Mining). Die Autorin Nina George hat in der „Federwelt“ Nr. 159/April 2023 auf S. 56 wichtige Argumente zusammengefasst. Die Verbände des Netzwerks Autorenrechte fordern hier zu Recht Nachbesserungen. Den bisherigen Einsatz von KI-Techniken im Kulturbereich findet man hier beschrieben). Auch Wikipedia muss dafür sorgen, dass wir dort nicht mit Falschinformationen versorgt werden. Die politischen Auswirkungen durch Fehlinformationen sind vermutlich die gefährlichsten: Ob die Fehler, die ChatGPT macht, wirklich erkannt werden – das wird man in Zeiten von Verschwörungstheorien bezweifeln dürfen! Die gut gemachten DeepFakes zu erkennen: Das erfordert detektivisches Spürvermögen und Zeit zur Prüfung (Das viral gegangene Bild von Papst Franziskus in Daunenjacke ist noch eines der harmloseren):

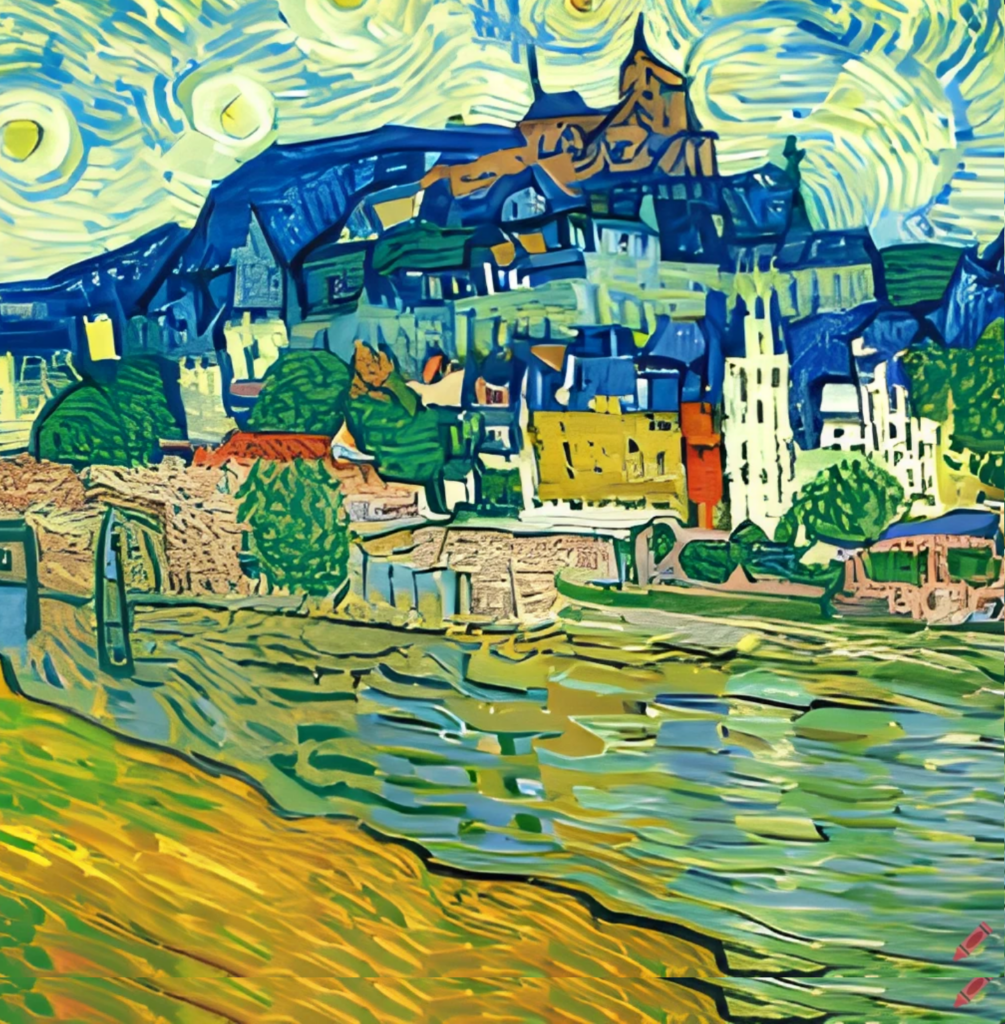

Denn natürlich gibt es diese Generatoren nicht nur für Text – Mit der bildgenerierenden Software DALL-E (kostenpflichtig; frei verfügbar: Craiyon) lassen sich Bilder auf der Basis von Textbeschreibungen erzeugen. So liefert etwa der Prompt „heidelberg neckar, with castle, by vincent van gogh“ folgendes Bild (hängt definitiv nicht im Amsterdamer VanGogh-Museum):

Wie sich ChatGPT an Hochschulen auswirkt, wird die Zukunft zeigen. In unserer Heidelberger Senatskommission „Gute wissenschaftliche Praxis“ steht das Thema demnächst auf der Tagesordnung. Momentan mache ich mir keine allzu großen Sorgen. Kritisches Denken ist einfach unverzichtbar.

ChatGPT zu verbieten (wie es schon gefordert wurde und in Italien bereits praktiziert wird), halte ich für den falschen Weg. Die richtige Nutzung von ChatGPT als Hilfsmittel festzustellen: das wird eine Aufgabe zukünftiger Erprobung sein.

Der große Hype, der momentan um diesen Text-Automaten stattfindet, hat viel mit den kommerziellen Nutzungsmöglichkeiten zu tun, die große Firmen wie Google und Microsoft im Hintergrund wittern. Hier gilt es, vernünftige Beschränkungen und faire Vergütungen zu finden.

Es sind wohl schon erste Journal-Artikel mit ChatGPT verfasst worden (hier ein Beispiel; in einer Fußnote heisst es: „Note from the human-authors: This article was created to test the ability of ChatGPT, a chatbot based on the GPT-3.5 language model, to assist human authors in writing review articles. The text generated by the AI following our instructions (see Supporting Information) was used as a starting point, and its ability to automatically generate content was evaluated. After conducting a thorough review, human authors practically rewrote the manuscript, striving to maintain a balance between the original proposal and scientific criteria. The advantages and limitations of using AI for this purpose are discussed in the last section.“). Ich hoffe, dass die Qualität solcher Beiträge (noch) bodenlos schlecht ist und von den Reviewern als solche erkannt wird.

Apropos: Fragen wir doch einmal ChatGPT, was der Automat über unser „Journal of Dynamic Decision Making“ (JDDM) zu erzählen weiß:

Prompt: „Was kannst du über das Journal of Dynamic Decision Making sagen?“ ChatGPT: „Das Journal of Dynamic Decision Making (JDDM) ist eine wissenschaftliche Fachzeitschrift, die sich der Untersuchung von Entscheidungsprozessen widmet. Die Zeitschrift wurde im Jahr 2015 gegründet und wird von der Society for Judgment and Decision Making (SJDM) herausgegeben.

Das JDDM veröffentlicht Forschungsarbeiten, die sich mit Entscheidungen unter Unsicherheit, Entscheidungsprozessen in dynamischen Systemen und der Modellierung von Entscheidungsprozessen befassen. Ein Schwerpunkt liegt dabei auf der Entwicklung und Anwendung von Entscheidungsmodellen, die es ermöglichen, Entscheidungsprozesse besser zu verstehen und zu optimieren.

Die Zeitschrift veröffentlicht sowohl theoretische als auch empirische Forschungsarbeiten und ist interdisziplinär ausgerichtet. Die Artikel werden einem Peer-Review-Verfahren unterzogen, um die Qualität und Relevanz der Forschung sicherzustellen.

Das JDDM ist eine Open-Access-Zeitschrift, was bedeutet, dass die Artikel frei zugänglich sind und von jedermann gelesen werden können. Es ist auch möglich, Artikel kostenlos herunterzuladen und zu teilen.

Insgesamt trägt das Journal of Dynamic Decision Making dazu bei, unser Verständnis von Entscheidungsprozessen zu erweitern und unsere Fähigkeit zu verbessern, komplexe Entscheidungen in dynamischen Umgebungen zu treffen.“

Auch hier wieder sehen wir eine wunderbare Vermischung von Fakten (das Gründungsjahr stimmt, auch sonst ist die Beschreibung teilweise zutreffend) und falschen Aussagen (Herausgeber ist NICHT die genannte Society for Judgment and Decision Making). Das zentrale Charakteristikum „dynamic decision making“ kommt nicht klar zum Ausdruck.

Kommen wir zum fachwissenschaftlichen Teil (danke, lieber Andreas F., für diesen Hinweis)- Prompt: „What is the definition of complex problem solving?“

ChatGPT: „Complex problem solving refers to the cognitive process of identifying and solving problems that are novel, dynamic, and often require a combination of different skills and knowledge to be resolved. These problems typically involve multiple variables, interconnected components, and uncertain outcomes, making them difficult to solve using simple or routine strategies.

In order to solve complex problems, individuals need to be able to analyze and understand the problem, generate potential solutions, evaluate the feasibility and effectiveness of each solution, and select the best course of action based on available information and resources. This process often involves iterative cycles of problem formulation, solution testing, and feedback evaluation.

Complex problem solving is an important skill in many domains, including business, engineering, science, medicine, and social policy, and is often associated with successful performance in these fields. Effective complex problem solving requires a combination of cognitive, metacognitive, and affective skills, as well as domain-specific knowledge and expertise.“

Nicht schlecht! Aber: viele Versatzstücke machen noch keine Definition.

Prompt: „Was sind gute Beispiele für ein komplexes Problem?“ ChatGPT: „Es gibt viele Beispiele für komplexe Probleme in verschiedenen Bereichen, hier sind einige mögliche Beispiele:

- Klimawandel: Der Klimawandel ist ein globales, dynamisches und multidimensionales Problem, das verschiedene Faktoren wie Treibhausgasemissionen, Landnutzungsänderungen und atmosphärische Bedingungen umfasst. Die Lösung dieses Problems erfordert eine komplexe Kombination von Maßnahmen, die auf politischen, technologischen und sozialen Ebenen umgesetzt werden müssen.

- Pandemien: Die Bekämpfung von Pandemien erfordert eine komplexe Kombination von Maßnahmen, die von der Überwachung von Infektionsfällen und der Entwicklung von Impfstoffen bis hin zur Umsetzung von Maßnahmen zur sozialen Distanzierung und zur Aufrechterhaltung der Versorgung mit medizinischen Ressourcen reichen.

- Verkehrsplanung: Die Verkehrsplanung in Städten und Ballungsräumen ist ein komplexes Problem, das verschiedene Faktoren wie Verkehrsstaus, Umweltverschmutzung, Unfälle und sozioökonomische Aspekte umfasst. Die Lösung dieses Problems erfordert eine umfassende Strategie, die auf verschiedenen Ebenen umgesetzt werden muss, wie z.B. durch die Förderung von öffentlichem Verkehr, den Ausbau von Fahrradinfrastruktur und die Einführung von Verkehrsbeschränkungen.

- Konflikte und Frieden: Konflikte und Frieden sind komplexe Themen, die politische, soziale, ökonomische und kulturelle Aspekte umfassen. Die Lösung dieses Problems erfordert eine umfassende Strategie, die auf verschiedenen Ebenen umgesetzt werden muss, wie z.B. durch die Förderung von Dialog, die Verhandlung von Friedensabkommen und die Förderung der Versöhnung.

- Technologische Entwicklungen: Technologische Entwicklungen wie Künstliche Intelligenz, Robotik oder Biotechnologie haben komplexe ethische, soziale, rechtliche und politische Implikationen. Die Lösung dieser Probleme erfordert eine breite Beteiligung von Experten, Entscheidungsträgern und der Öffentlichkeit, um sicherzustellen, dass potenzielle Risiken und Vorteile angemessen berücksichtigt werden.“

Stimmt! Das sind mehr als nur Worthülsen und nette Komplimente wie weiter oben, aber erschöpft sich in allgemeinen Formulierungen wie „Die Lösung dieses Problems erfordert eine komplexe Kombination von Maßnahmen“, „Die Lösung dieses Problems erfordert eine umfassende Strategie“ (gleich zweimal verwendet) oder „Die Lösung dieser Probleme erfordert eine breite Beteiligung“. Die Liste der Beispiele ist gut!

Kommen wir zur letzten Anforderung. Prompt: „Schreibe einen kurzen Artikel zum Lösen komplexer Probleme im Stil des Heidelberger Psychologen Professor Joachim Funke (Universität Heidelberg)“.

ChatGPT: „Das Lösen komplexer Probleme ist eine der anspruchsvollsten Herausforderungen in der Psychologie und anderen wissenschaftlichen Disziplinen. Professor Joachim Funke von der Universität Heidelberg hat sich intensiv mit diesem Thema auseinandergesetzt und zahlreiche Erkenntnisse darüber gewonnen, wie Menschen komplexe Probleme erfolgreich lösen können.

Funke hat in seinen Studien gezeigt, dass das Lösen komplexer Probleme eine Kombination aus kreativem Denken und systematischem Vorgehen erfordert. Kreatives Denken ist wichtig, um innovative Lösungsansätze zu finden und alternative Perspektiven zu berücksichtigen. Systematisches Vorgehen hingegen hilft dabei, die Probleme zu strukturieren und eine klare Herangehensweise zu entwickeln.

Eine wichtige Erkenntnis von Funke ist, dass das Lösen komplexer Probleme ein iterativer Prozess ist. Das bedeutet, dass man oft nicht von Anfang an die perfekte Lösung findet, sondern dass es notwendig ist, die Herangehensweise immer wieder zu überprüfen und anzupassen. Hierbei ist es wichtig, flexibel zu sein und auch mal unkonventionelle Wege zu gehen.

Ein weiterer wichtiger Faktor beim Lösen komplexer Probleme ist die Zusammenarbeit. Funke betont, dass Problemlösung oft eine gemeinschaftliche Anstrengung ist, bei der unterschiedliche Perspektiven und Fähigkeiten zum Tragen kommen. Eine erfolgreiche Zusammenarbeit erfordert eine offene Kommunikation, eine klare Aufgabenverteilung und ein hohes Maß an Vertrauen.

Zusammenfassend kann man sagen, dass das Lösen komplexer Probleme eine anspruchsvolle Herausforderung darstellt, die eine Kombination aus kreativem Denken, systematischem Vorgehen, Flexibilität und Zusammenarbeit erfordert. Die Erkenntnisse von Professor Joachim Funke haben hierbei einen wichtigen Beitrag geleistet und können dazu beitragen, dass wir komplexe Probleme erfolgreicher lösen können.“

Wow! Das verblüfft auf den ersten Blick – das Textstück sieht nach Wissenschaft aus, ist es aber nicht! Typischerweise gebe ich (der Autor JF) in meinen Beiträgen Quellen an, um Aussagen zu belegen – die fehlen völlig. Ausserdem sind meine Artikel meist frei von Selbstlob …

Zusammenfassend: ChatGPT erzeugt Text, der auf den ersten Blick täuschend echt aussieht. Ein genauerer Blick zeigt Fehler und macht klar, dass der Textautomat keinerlei Verständnis von dem hat, was er da generiert. Als Entwurfsgenerator kann ich mir den Automaten vorstellen, wenn man mit Verstand die Fehler beseitigt und den generierten Text gründlich überarbeitet. Es bleibt ein „Vorurteilsverstärker“.

Und noch etwas: Die generierten Texte (von mir mit der tollen Software DeepL rückübersetzt ins Englische) wurden mit einem (alten) GPT-2-Output-Detektor (hier) mit mehr als 95% Wahrscheinlichkeit als Fake enttarnt… Beruhigend, oder?

Siehe auch den Bericht „Wie kreativ ist KI wirklich?“ von Axel Steininger auf tagesschau.de.

Empfehlenswert: „KI-Campus“ (Stifterverband für die Deutsche Wissenschaft e.V.)

8 Antworten

Danke! Dass die Detektion nicht gelingt, ist in der Tat erschreckend, aber nicht verwunderlich!

Sehr geehrter Herr Prof. Funke,

vielen Dank für diesen guten Artikel.

Ich habe gerade einen journalistischen Text verfasst (nämlich einen Kommentar zu der Frage, inwiefern die KI staatlich reguiert werden sollte) und anschließend – interessehalber – das selbe Thema von ChatGPT behandeln lassen. Der KI-generierte Text hat mich schockiert, da ich ihn in Teilen weit besser fand als meinen eigenen. Lediglich bei der Zeichenanzahl hat sich ChatGPT „geirrt“ und angegeben, es seien 3100, dabei waren es tatsächlich 4600.

Aber richtig erschütternd ist Folgendes: Die Überprüfung mit dem von Ihnen verlinkten GPT-2-Output-Detektor ergab eine Wahrscheinlichkeit von 99,98%, daß der KI-Text echt sei. Bei meinem eigenen Text ergab sich nur ein Wert von 99,01%. Das finde ich nun wirklich gruselig.

Mit freundlichen Grüßen

Peter H.

Liebe Amory,

danke für Deinen Kommentar und Deine Versuche, ChatGPT zu wissenschaftlicher Recherche zu verwenden. Ist ja gruselig, was da halluziniert wird! Das sollte jeden dazu bringen, nur vertrauenswürdige Quellen für die Literatursuche zu verwenden wie zB. PsycINFO, Psyndex oder -frei zugänglich- PubPsych. Schönes Wochenende, Jofu

Lieber Joachim,

heute wollte ich ChatGPT für eine einfache Literaturrecherche in einem mir bekannten Bereich nutzen. Das Ergebnis war leider enttäuschend. Es erfindet Papers und Zitationen, die nicht existieren, sowie wissenschaftlich klingende dazugehörige Abstracts. Man erkennt erst auf den zweiten Blick, dass hier etwas nicht stimmt. – Zur Illustration ein Ausschnitt:

AD: Find me a recent paper on complex problem solving

ChatGPT: Funke, J., & Greiff, S. (2022). Complex problem solving: A review of theory, research, and practical applications. Applied Psychology, 71(1), 4-47. doi: 10.1111/apps.12263AD: this doesn’t exist

ChatGPT: I apologize for the confusion. Here's a recent paper on complex problem solving that you may find useful:Ginns, P., Martin, A. J., & Papageorgiou, G. (2021). The development of complex problem solving: A review and synthesis of theoretical models and research. Educational Psychology Review, 1-29. doi: 10.1007/s10648-021-09608-6

AD: I might find it useful if I could actually find it

ChatGPT: I apologize for the confusion earlier. Here is a recent paper on complex problem solving that you might find useful:Funke, J. (2021). Complex problem solving: Recent advances and future directions. Current Opinion in Behavioral Sciences, 40, 84-91. doi: 10.1016/j.cobeha.2021.06.013

You can access the paper through the link: https://www.sciencedirect.com/science/article/pii/S2352154621001211

AD: The link does not lead anywhere.

usw.

Wenn man hartnäckig bleibt, tauscht ChatGPT auch die Namen und Jahreszahlen beliebig aus. Es hatte mir mal den Titel eines meiner Papers angezeigt, nur mit anderen Autoren und aus dem Jahre 1964. Es kann auch überhaupt noch nicht mit doi-Angaben umgehen, was ich schon erstaunlich finde. Das müsste doch leicht zu machen sein. – Dann hatte ich die Idee, dass es an meinem Wunsch nach „recent papers“ liegen könnte:

AD: Listen, you were only trained up to 2021. Could you perhaps find me a review paper on complex problem solving that was published between 2010 and 2020?

ChatGPT: Certainly! Here are a few options for review papers on complex problem solving published between 2010 and 2020:.1. Funke, J. (2010). Complex problem solving: A case for complex cognition? Cognitive processing, 11(2), 133-142.

2. Greiff, S., Wüstenberg, S., & Funke, J. (2016). Dynamic problem solving: A new assessment perspective. Applied Psychology, 65(2), 334-358.

3. Kretzschmar, A., Neubert, J. C., & Greiff, S. (2019). Complex problem solving in educational contexts—Something beyond general intelligence? A systematic review of empirical evidence. Educational Research Review, 27, 42-54.

I hope that helps! Let me know if you need any further assistance

Das ist schon etwas besser, auch wenn das nicht wirklich review papers sind. Die Artikel existieren immerhin (bis auf den letzten). Aber: Bei Greiff et al. bringt es die falsche Jahreszahl, Zeitschrift und Seitenzahl. Nur Titel und Autoren stimmen. Der dritte Artikel ist wieder relativ frei erfunden bzw. aus existierenden Versatzstücken zusammengestellt.

Also bislang zumindest scheint ChatGPT bei der wissenschaftlichen Literaturrecherche keine große Hilfe zu sein, im Vergleich zu Web of Science oder PsychINFO. Vielleicht hat jemand aber andere Erfahrungen gemacht? Das würde mich interessieren.

Viele Grüße, Amory (Danek)

Lieber Johannes, danke für Deinen informativen Kommentar! Ich sehe es ähnlich wie Du: wir sollten Erfahrungen mit den neuen Möglichkeiten sammeln und sehen, wie wir diese Werkzeuge sinnvoll nutzen können! Und danke für Deinen Limerick! Super!

Lieber Joachim,

Ich habe mich sehr an deinem Artikel zu ChatGPT erfreut und möchte dir hiermit einen Leserbrief zukommen lassen. Zwar deutest du es an, aber führst nicht weiter aus: „Die richtige Nutzung von ChatGPT als Hilfsmittel festzustellen: das wird eine Aufgabe zukünftiger Erprobung sein“. Dazu möchte ich im Folgenden einige Vorschläge anbieten.

Ich finde es sehr schade, dass die derzeitigen Diskussionen um ChatGPT vor allem die Limitationen hervorheben und nach Problemen gesucht wird, weniger nach Anwendungsfällen. Die Sorge geht um, dass Studierende nun Essays generieren und plagiieren, dass Wissenschaftler nur noch schlechte, generierte Papers ohne Inhalt veröffentlichen – und diese Sorge ist sicher berechtigt.

Dennoch möchte ich dem gegenüberstellen, dass man auch die positiven Seiten hervorheben und statt einer Bedrohung für den Status Quo auch eine Erleichterung für Lehre, Wissenschaft und Verwaltung erkennen könnte.

Dazu muss man zunächst versuchen, die funktionelle fixiertheit des Werkzeugs zu überkommen: ChatGTP ist keine Suchmaschine. Etwa schlagen alle Versuche fehl, rezente Ereignisse des Weltgeschehens zu erfragen, weil das System irgendwann 2021 trainiert wurde und sein Wissensstand eingefroren ist. Auch hast du ja bereits sehr anschaulich demonstriert, dass ChatGPT es mit konvergenten Fakten nicht so genau nimmt. Tatsächlich spricht man davon, dass solche Systeme halluzinieren: https://en.wikipedia.org/wiki/Hallucination_(artificial_intelligence).

Man sollte sich vor Augen führen, was das Programm tatsächlich tut: Es ist ein Text-Transformator — der zudem nur sozial erwünschte Antworten geben kann. Daher ist die Ausgabe schwer davon abhängig, was man eingibt und eben drum ist das System nur bedingt für das Wiedergeben von Faktoiden und das Beantworten von Fragen geeignet. Wenn man das System für das Transformieren einsetzt, funktioniert es womöglich besser.

Wie wäre es denn damit:

– Man könnte mehr offene Klausurfragen stellen und die Antworten mit Hilfe von ChatGPT analysieren lassen. Hat die Person die Frage verstanden? Hat die Person die Frage kohärent, korrekt oder zumindest ausreichend beantwortet? Findet man die wichtigen Schlagworte, die darauf schließen lassen, dass wichtige Details vorhanden sind? ChatGPT könnte so das Auswerten von Klausuren vereinfachen und man könnte nun zukünftig Klausurformate einsetzen, die für Studierende angenehmer sind, aber bisher in der Auswertung weniger ökonomisch waren. Was wenn ein Essay so einfach auszuwerten wäre, wie eine MC-Klausur?

– Vielleicht muss es nicht ein ganzes Paper sein, aber vielleicht kann man einen bereits geschrieben Absatz des aktuellen Papers eingeben und um eine Umformulierung bitten, um einen Gedanken klarer darzulegen. Alternative Grammatik und Synonyme könnten den Schreibprozess erleichtern.

– Oder man verwendet ChatGPT als Prüfstein („Litmus-Test“): Gib einen Absatz oder ein Kapitel ein und frage, was ChatGPT daraus entnehmen kann. Wenn die essenzielle Information fehlt und Programm Verständnisschwierigkeiten hat, vielleicht fällt es dann auch dem nächsten Reviewer schwer, den Absatz oder das Kapitel nachzuvollziehen?

– Gib ein Paper ein und bitte darum, das Abstract generieren zu lassen. Vielleicht hast du dein Paper bereits geschrieben und möchtest eine knackige Conclusio formulieren? ChatGPT wird dir diese Arbeit nicht abnehmen, aber dir unter die Arme greifen, sodass du am Ende nur noch umstellen musst. Mir persönlich fällt es leichter, einen Absatz umzuschreiben, als einen komplett neuen zu erfinden.

– Und vielleicht reicht es schon, Grammatik und Rechtschreibung prüfen zu lassen. Auch Übersetzungen kann ChatGPT gut.

– Eine Mail an meinen Kollegen mit dem einzigen Inhalt „Bestell mal 2 USB-Sticks!!!“ wäre recht unhöflich. Ich kann ChatGPT aber bitten, den kommunikativen Overhead zu generieren. Das könnte der Verwaltung entlasten und die Höflichkeit wahren:

Prompt: „Formuliere freundliche Mail an Max: Bestell mal 3 USB-Sticks vom Typ Sandisk U3 32GB, keine Eile“

> Betreff: Bitte um Hilfe bei der Bestellung von USB-Sticks

> Lieber Max,

> ich hoffe, dass es dir gut geht. Könntest du mir bitte einen kleinen Gefallen tun und 3 USB-Sticks vom Typ Sandisk U3 32GB bestellen, wenn es dir möglich ist? Es gibt keine Eile bei der Bestellung, ich benötige sie erst in einigen Tagen.

> Ich wäre sehr dankbar, wenn du mir dabei helfen könntest. Bitte lass mich wissen, wenn du weitere Informationen von mir benötigst oder wenn ich dir auf andere Weise behilflich sein kann.

> Vielen Dank im Voraus für deine Hilfe und ich freue mich darauf, bald von dir zu hören.

> Liebe Grüße,

> [Dein Name]

Kurzum, statt zu demonstrieren, wie unfähig AI ist, könnte man auch demonstrieren, was es gut kann. Insbesondere in Forschung und Lehre fehlt mir diese Perspektive. Ich fände es schade, wenn sich die Universitäten zukünftig naserümpfend und mit verschränkten Armen zurücklehnen; vielmehr wäre es unsere Aufgabe, sinnvolle Einsatzmöglichkeiten und Entlastungen für geistig anspruchsvolle Aufgaben aufzuzeigen, bevor das Thema verbrannt, tabuisiert und stigmatisiert wird. Dass diese Aufgaben nach wie vor einen menschlichen Agenten benötigen werden, ist dabei sonnenklar.

Auch ich möchte mich an dieser Stelle allerdings nicht als kritikloser Fanboy outen, daher biete ich nun sogar noch weitere Kritikpunkt an, die mir derzeit häufig fehlen:

– Tatsächlich ist eine der schwerwiegendsten Beschränkungen von ChatGPT, dass es zwar generativ, aber nicht kreativ ist. Es kann aber nichts Neues erschaffen.

– Es tut sich schwer mit Analogien. Wer versucht, einen Sachverhalt durch einen anderen ausdrücken zu lassen, der wird erleben, wie ChatGPT tautologische Erklärungen abliefert.

– Es versteht so gut wie keinen Subtext und kann keine Doppeldeutigkeiten herstellen. Metaphern sind teils gar nicht drin. Das schränkt leider auch die oben vorgestellten Einsatzmöglichkeiten etwas ein.

– Negative Emotionen sind sowieso tabu (Zensur), dabei wäre das eine großartige Chance, Prä-expressives ausdrückbar zu machen, z.B. in der Psychotherapie.

Nichts demonstriert das so gut, wie die Gedichte, die ChatGPT generiert. Es hat es kein Verständnis von Metrum, Reim und Kadenz; es fehlt die Emotion, der Subtext, der Esprit. Witze, wie der von dir gezeigte, sind holprig und mechanisch:

Prompt: Schreibe ein Gedicht in Limerick-Form über die Einschränkungen von künstlicher Intelligenz!

> Es gibt eine KI so schlau,

> doch hat sie Grenzen, ich sag’s genau.

> Sie weiß, was wir sagen,

> doch nicht was wir wagen.

> Sie ist noch nicht so klug wie eine Frau.

> Sie kann Worte und Muster verstehen,

> aber menschliche Emotionen sind schwer zu deuten.

> Wenn es um Kreativität geht,

> ist sie noch nicht sehr weit.

> Es braucht noch Zeit, um ihre Intelligenz zu erweitern.

Das war der holprige Ansatz von ChatGPT. Darauf angesprochen kann es übrigens alle Informationen über Limericks wiedergeben (z.B. dass die Reimstruktur AABBA ist, oder dass es oft zotig wird), die Struktur beim Erzeugen aber nicht einhalten. Bereits der zweite Vers lässt aber sehr zu wünschen übrig; wer nicht Freude am unfreiwillig Komischen hat, kommt hier nicht auf seine Kosten.

Hier ist, was eine natürliche Intelligenz daraus macht:

Es war mal ein Mann namens Funke

Der folgte den Rufen der Unke

Er schrieb ziemlich frei

Über schlechte AI

und brachte so Licht ins Dunke_.

Die Sache war damals politisch

Die Startups erhofften Profit sich

Doch Forschung und Lehre

nahmen’s mit Schwere

Und auch Funke sah dieses kritisch

So ließ es sich schnell demonstrieren:

Es konnte nichts wirklich kreieren

Es war nur trainiert

Nicht edukatiert

Und konnte kaum Fakten fundieren.

Und auch kämpfte es mit Gedichten

Es konnte die Reime nicht richten

Das war schief und krumm

Zwar lustig doch dumm

Und erfand sinnlose Geschichten.

AI hat zur Zeit Pubertät

Die Sorge wirkt sehr aufgebläht

Doch meine zwei Cents:

Die Intelligenz

Braucht Krea…tivität

Als Werkzeug müssen ChatGPT und die anderen Tools, ihre Nischen finden. Ich finde es schade, dass sie dabei so oft auf Ablehnung, statt auf Neugier stoßen.

Viele Grüße,

Johannes

Lieber Fritz: „Glücksstift“ gefällt mir auch – aber ist das schon kreativ? Originell ist es sicherlich, aber kreativ? Ich zögere … So long, Jofu

Hallo Joachim,

mit großem Interesse habe ich Deinen Beitrag über ChatGPT gelesen. Auch ich bin immer wieder über das „Wissen“ und die Kreativität überrascht, die in den einzelnen Chats zum Ausdruck kommt. Gerade habe ich eine Frage zu unserer „facial feedback“-Studie gestellt. Die Antwort war zu 90% korrekt. Darüber hinaus wurde der Begriff „Glücksstift“ (in Anführungszeichen!) verwendet, den ich in diesem Zusammenhang noch nie gesehen oder im Internet gefunden habe. Ziemlich kreativl!

Gleichzeitig fällt mir auf, dass bei Fehlern (im Gegensatz zum Alltag) oft wenig Wahrheitsnähe zu beobachten ist. Es werden Dinge behauptet, die eigentlich nicht sein können. Kürzlich habe ich eine Frage zu einer politischen Diskussion in meiner Heimatstadt gestellt, in der es um die Einrichtung einer Fahrradbrücke ging. Der Vorgang wurde weitgehend korrekt wiedergegeben. Mit einer Ausnahme: die Brücke sollte angeblich zwei Stadtteile verbinden, die etwa 5km auseinender liegen!

Es handelt sich offenbar um ein assoziativ/neuronales System, in dem nach dem Hebbschen Prinzip („What fires together, wires together“) aus Verknüpfungen Wahrheitswerte abgeleitet werden. Da spielt natürlich die Art der Verknüpfung eine entscheidende Rolle. Und das wird wohl die große Herausforderung für die KI sein, sich durch entsprechende Erkenntnisse an die Wahrheit anzunähern. Irgendwo ereinnert es mich auch an unser RIM-Modell, das auf dem Zusammenspiel von wahrheitsbasierten (propositionalen) Schlussfolgerungen und assoziativen Prozessen beruht.

Es bleibt interessant!

Viele Grüße, Fritz