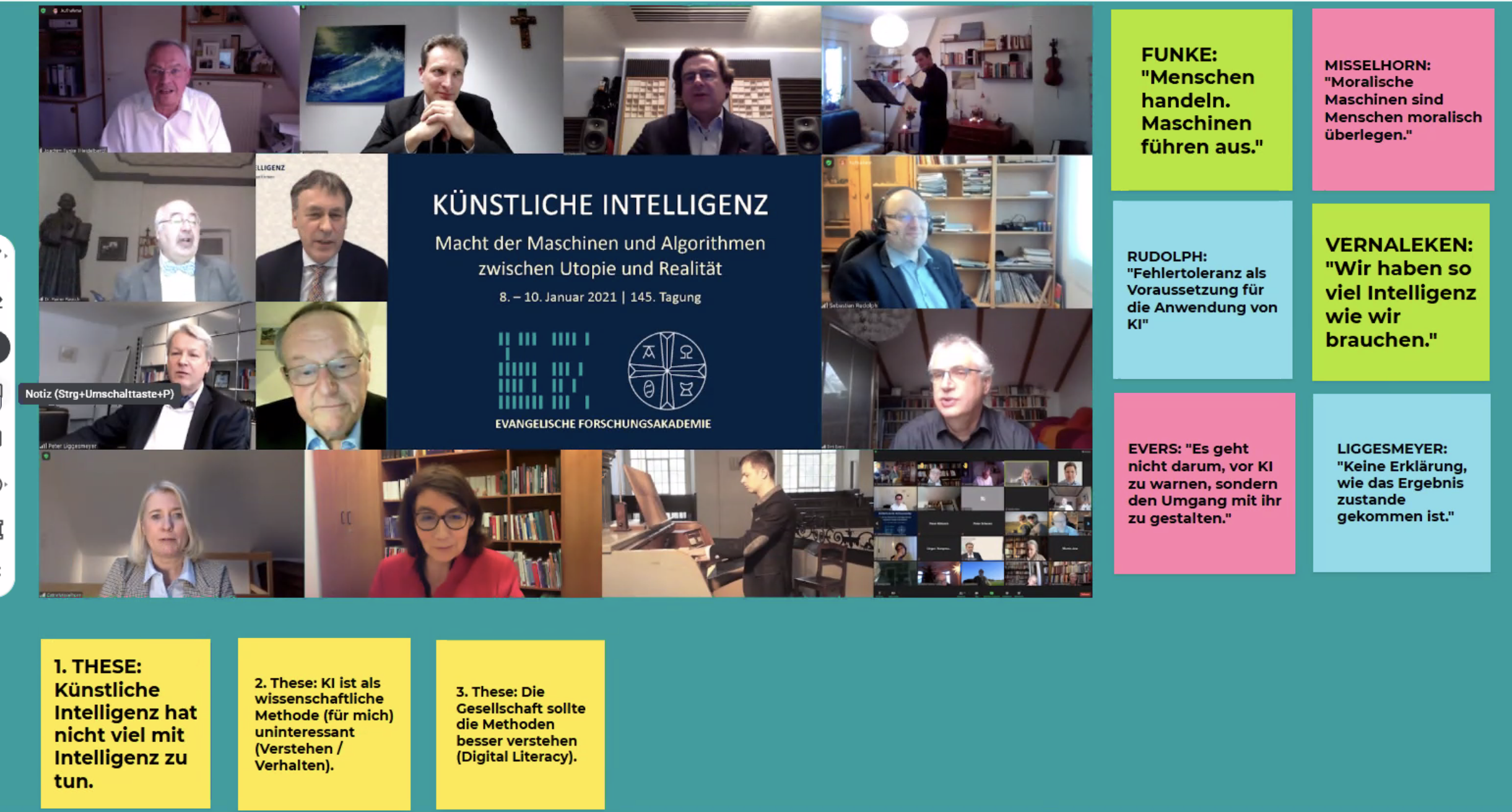

Ich hätte dieses Wochenende (8.-10.2021) eigentlich in Berlin verbringen sollen – die Evangelische Forschungsakademie hatte mich eingeladen, den Eröffnungsvortrag ihrer 145. (sic!) Tagung zu halten, die unter dem Thema „Künstliche Intelligenz. Macht der Maschinen und Algorithmen zwischen Utopie und Realität“ stand. Wie heute fast schon üblich, fand diese Konferenz – für die Akademie zum ersten Mal – virtuell via Zoom mit etwa 60 Teilnehmenden statt.

Über meinen Eröffnungsvortrag, der die menschliche Intelligenz von künstlicher abgegrenzt hat (Merksatz: „Menschen handeln, Maschinen führen aus“) will ich hier nicht weiter berichten. Wohl aber gab es ein paar Beiträge, die mir bedenkenswerte Aspekte zum Themenfeld künstlicher Intelligenz aufgezeigt haben. Darüber will ich ein paar Zeilen schreiben.

Der Informatiker Peter Liggesmeyer (TU Kaiserslautern) machte Stärken und Schwächen maschineller Systeme deutlich. Er verglich konventionelle mit Ki-Programmen: Die konventionellen Programme sind zwar unflexibel, dafür einwandfrei feststellbar, d.h, deren Ergebnisse sind erklärbar. Maschinelles Lernen (KI-Programme) ist flexibel, lernfähig, aber nur mangelhaft reproduzierbar, Ergebnisse sind nicht leicht erklärbar.

Ausführlich ging Liggesmeyer auf die Gefahren lernender Algorithmen ein – die Beispiele (z.B. Eykholt el al. 2018, doi: 10.1109/CVPR.2018.00175, über ein Stop-Schild, das plötzlich als Geschwindigkeitsbegrenzung gedeutet wid; Metzen et al. 2017, http://arxiv.org/abs/1704.05712, über eine Bildverarbeitung, bei der für das menschliche Auge sichtbare Fußgänger aus KI-Sicht unsichtbar werden) zeigen potentielle Unfallquellen für autonome Fahrzeuge auf). Das weite Feld der adversarial examples kam hier zur Sprache, das unser Vertrauen in maschinelle Lernverfahren etwas erschüttert.

Apropos: Autonomes Fahren wird vielleicht schneller kommen, als wir es heute für möglich halten – vielleicht auch zunächst nur auf bestimmten Strassen wie z.B. Autobahnen, wo (zumindest unter akzeptablen Wetter-Bedingungen) überschaubare Situationsklassen auftreten (normalerweise keine Radfahrer, keine Fußgänger, keine überraschenden Wegführungen). Auf der anderen Seite stehen Sicherheitsbedenken: der Tesla-Autopilot-Unfall mit tödlichem Ausgang macht schmerzlich klar, dass die angestrebten Sicherheitsstandards für selbstfahrende Autos noch nicht erreicht werden. Der autonome Tesla bringt es zur Zeit auf einen tödlichen Unfall auf insgesamt 210 Millionen gefahrene Kilometer. In der Vergangenheit (im 19. Jahrhundert) wurde übrigens eine neue Technologie namens „Dampfmaschine“ eingeführt, als längst noch nicht alle Probleme dieser Technologie gelöst waren und die Dampfkessel noch reihenweise explodierten („Learning from ignorance“ von Jim Thomson 2013 über Dampfkessel-Explosionben in den USA; hier ein Bericht vom TÜV über historische Dampfkessel-Explosionen in Baden-Württemberg aus dem Jahr 2016). Manche Technologien drängen auf den Markt und warten nicht auf kritische Prüfung…

Weil heute Daten wichtiger als Algorithmen sind (die Qualität eines maschinellen Lernprogramms hängt vor allem von Menge und Qualität der Trainingsdaten ab), sind große Konzerne wie Facebook und Google in einer Spitzenposition. Liggesmeyer machte deutlich, dass wir uns mehr über die sinnvolle Verwendung unserer Daten als über deren Verbergen (klassischer Weg: „Datenzugangskontrolle“) Gedanken machen sollten – das neue Konzept dabei heisst „Datennutzungskontrolle“ (hier ein Erklär-Video vom Fraunhofer-Institut) und soll berechtigten Nutzern (z.B. Ärzte, Behörden) unserer Daten den Zugriff gewähren. Die Bundesregierung hat dazu eine neue Datenstrategie beschlossen.

Der Komponist Franz Danksagmüller (Lübeck) zeigte in seinem Beitrag anhand musikalischer Beispiele, wie Algorithmen Musik „im Stil von“ XY (Bach, Mozart, Michael Jackson) produzieren. Offensichtlich keine neue Entdeckung, weil bereits Mozart eine Anleitung zur Komposition von Walzer-Musik zugeschrieben ist, die mit gewürfelten Zahlen bestimmte Teilstücke immer neu zusammenfügt (sog. „Würfelmusik„). „Ergreifend“ sind diese Kompositionen noch nicht (hier ein durchaus eindrucksvolles Beispiel aus dem Linzer Museum „Ars Electronica„), aber sie werden immer besser 🙂 Der Google Doodle zu Ehren von Johann Sebastian Bachs Geburtstag am 21.3.2019 war der erste Doodle überhaupt, der mit AI gespeist war und ein umfangreiches #BachDoodle-Team mit großer Expertise hinter sich stehen hatte (das Video erklärt den Hintergrund).

Zum Thema Ethik habe ich einiges über Maschinenethik gehört – ein neues Forschungsgebiet an der Schnittstelle von Philosophie, Robotik und Informatik. Die Philosophin Catrin Misselhorn (Uni Göttingen) hatte Spannendes beizutragen. Gibt es bei einem selbstfahrenden Staubsauger ethische Probleme? Ich hätte spontan „nein“ gesagt, aber Frau Misselhorn brachte den Maikäfer ins Spiel, den ich vielleicht doch lieber vor dem Aufsaugen gerettet wissen möchte… Und tatsächlich gibt es das Ladybird-Projekt, in kleiner, mobiler Saugroboter, der Marienkäfer bzw. ähnliche Objekte erkennt und bei ihrer Anwesenheit seine Arbeit unterbricht – eine „moralische Maschine“ also. Ihrer steilen These, dass moralische Maschinen in einem funktionalen Sinn Menschen moralisch überlegen seien, kann ich nicht zustimmen – zu sehr gehen mir dabei die Stufen der Moralentwicklung nach Lawrence Kohlberg durch den Kopf (an denen man natürlich vieles kritisieren kann, aber nicht hier): Maschinen sehe ich (allenfalls) auf dem Level konventioneller Moral gefangen, während Menschen zu post-konventionellen Moralentscheidungen fähig sind. Weisheit spielt dabei eine nicht unwichtige Rolle, die ich bei einer Maschine nicht erkennen kann. Aber vielleicht sollte ich erst einmal ihr Buch „Grundfragen der Maschinenethik“ (2018, 4. Aufl. bei Reclam) lesen …

Der Theologe Dirk Evers (Uni Halle) hat in seinem Beitrag über „Gottebenbildlichkeit und KI“ den „Authentizitätswahn“ (Thomas Bauer) unserer Epoche angesprochen („Diktatur der Freiheit“ nach Eric Schmidt, Google-CEO von 2001-2011, und dem Philosophen Richard David Precht: KI gibt mir Antworten darauf, was ich tun könnte; ein Beispiel: Der Wahlomat hilft bei der Suche auf die Frage „wen soll ich wählen?“). In diesen „Überforderungsdynamiken der Moderne“ bietet KI eine Entlastung vom Entscheidungsdruck, die wir anscheinend dankbar annehmen.

Am Beispiel von Seerobbe („Pflege-Robbe“) Paro und Computerhund Aibo wurde zugleich deutlich, dass solche künstlichen Knuddeltiere durchaus eine therapeutische Funktion erfüllen können, aber immer der „Modus des zweifachen Bewusstseins“ (Christopher Scholtz; hier ein Aufsatz von Scholtz zum Thema) gesehen werden sollte, wonach wir uns bewusst darüber sind, keine lebendigen Wesen vor uns zu haben. Politisch verband Evers diesen Gedanken mit der Forderung, dass in jeder Interaktion mit einem Maschinenwesen (Roboter, „Bot“ etc.) sich dieses als Maschine zu erkennen geben müsse – eine tolle Forderung, wie ich finde! Denn Maschinen haben keine Würde, können daher auch einfach abgestellt werden – wir gehen keine sozialen Verpflichtungen mit Maschinen ein! Menschenwürde: unbedingt! Maschinenwürde: nein!

Noch eine letzte politische Forderung von Dirk Evers, die bei mir hängengeblieben ist: „Daten sollten vergesellschaftet werden“. Momentan liefern wir unsere persönliche Daten im Gegenzug für eine meist kostenlose Nutzung von Webdiensten. Dabei könnte man viele dieser Daten für gesamtgesellschaftlich nützliche Zwecke verwenden statt sie privaten Firmen zur Nutzung zu überlassen (Beispiel Taxiunternehmen Uber: siehe z.B. den Vortrag von Mirko Herberg „What if the citizens of Berlin owned Uber’s data?“).

Ich wusste gar nicht, wie politisch Theologen sein können! Danke an die Referenten und die Referentin für die vielen Anregungen, danke für das „food for thought“, das in meine Handschuhsheimer Dachstube gelangen durfte! Ein Weiterbildungs-Wochenende der besonderen Art! Danke für die Einladung!

Hier Links zu den aufgezeichneten Vorträgen:

- Joachim Funke: https://youtu.be/K3W5jl6woi4

- Ingo Bernd Vernaleken: https://youtu.be/lkVJQD46VKM

- Franz Danksagmüller: https://youtu.be/gKuQz0AQkZQ

- Sebastian Rudolph: https://youtu.be/x42Hn5fJRE4

- Peter Liggesmeyer: https://youtu.be/2QKwVcvefS8

- Dirk Evers: https://youtu.be/0jEu1hUtFpc

- Rainer Rausch / Tim Reiter: https://youtu.be/LeiRztMwYAs