Wie nicht anders zu erwarten, geht die schon seit mehreren Jahren andauernde Reproduzierbarkeits-Debatte weiter. Nachdem im August 2015 in der Top-Zeitschrift „Science“ mit viel Publizität über die gross angelegten Replikationsstudien der „Open Science Foundation“ (OSF) berichtet wurde

Wie nicht anders zu erwarten, geht die schon seit mehreren Jahren andauernde Reproduzierbarkeits-Debatte weiter. Nachdem im August 2015 in der Top-Zeitschrift „Science“ mit viel Publizität über die gross angelegten Replikationsstudien der „Open Science Foundation“ (OSF) berichtet wurde

Open Science Collaboration (2015). Estimating the reproducibility of psychological science. Science, 349(6251), 1–8. doi:10.1126/science.aac4716

und die Ergebnisse nicht sehr rosig ausfielen (um es mal ganz freundlich zu formulieren), ist gerade letzte Woche die Debatte in „Science“ fortgesetzt und erneut aufgeheizt worden. Diesmal wird mit viel Publizität eine gegenteilige These vertreten.

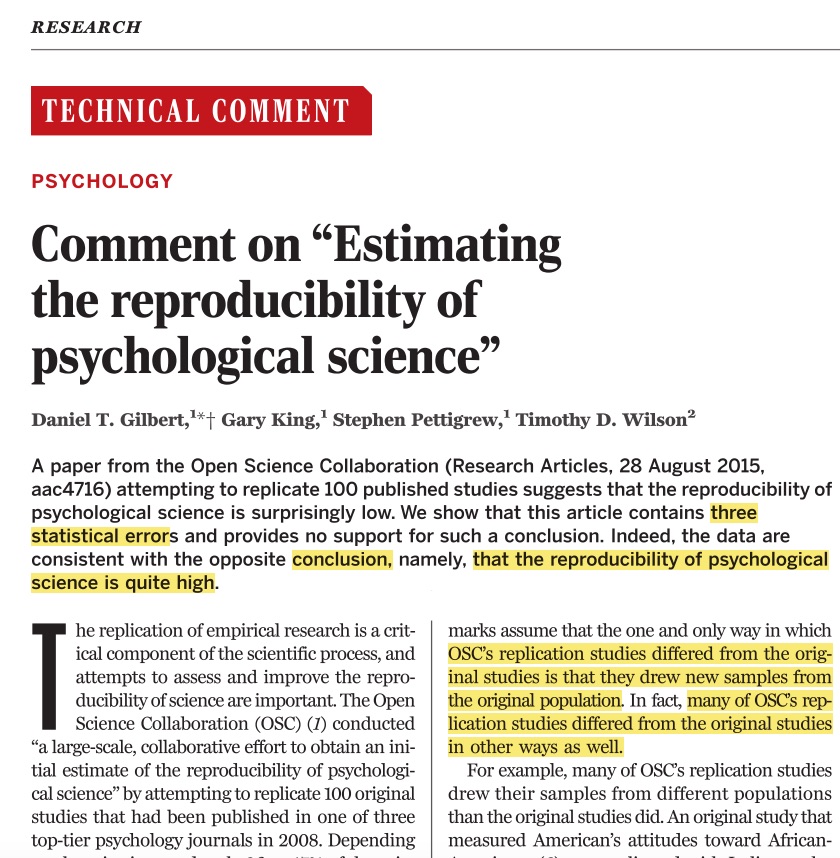

In dem Beitrag von Gilbert et al. (2016)

Gilbert, D. T., King, G., Pettigrew, S., & Wilson, T. D. (2016). Comment on “Estimating the reproducibility of psychological science.” Science, 351(6277), 1037–a. doi:10.1126/science.aad7243

wird ein für das Fach sehr positives Urteil gefällt, nämlich „that the reproducibility of psychological science is quite high“!

Wie kann es sein, dass die eine Studie (die Originalarbeit der OSF-Gruppe) zu einer kritischen Bewertung kommt (OSF 2015: „39% of effects were subjectively rated to have replicated the original result; and if no bias in original results is assumed, combining original and replication results left 68% with statistically significant effects“), während eine erneute Analyse des gleichen Datenmaterials zu einer völlig konträren Einschätzung gelangt: „we show that when these results are corrected for error, power, and bias, they provide no support for this conclusion. In fact, the data are consistent with the opposite conclusion, namely, that the reproducibility of psychological science is quite high“ (Gilbert et al., 2016). Offensichtlich besteht Klärungsbedarf!

Die durch Gilbert et al. heftig kritisierte OSF-Autorengruppe erhielt nach guter wissenschaftlicher Praxis Gelegenheit zur Erwiderung auf diese Kritik:

Anderson, C. J., Barnett-Cowan, M., Bosco, F. A., Chandler, J., Chartier, C. R., Cheung, F., … Zuni, K. (2016). Response to Comment on “Estimating the reproducibility of psychological science.” Science, 351(6277), 1037b. doi:10.1126/science.aad9163

Die Einschätzung dieser Gruppe sieht natürlich etwas anders aus: „Their [Gilbert et al.] very optimistic assessment is limited by statistical misconceptions and by causal inferences from selectively interpreted, correlational data. Using the Reproducibility Project: Psychology data, both optimistic and pessimistic conclusions about reproducibility are possible, and neither are yet warranted.“ Wenn man sich diese Erwiderung im Detail anschaut, kommt man zu dem Schluss, dass Gilbert et al. sich – nicht ganz fair – bestimmte Kriterien herausgegriffen und fehlerhafte Schlüsse gezogen haben.

Dass aus ein-und-demselben Datensatz unterschiedliche Schlüsse gezogen werden, wundert mich nicht – in einer sehr schön dokumentierten Arbeit aus dem Jahr 2015 haben Silberzahn et al.

Silberzahn, R., Uhlmann, E., Martin, D., Anselmi, P., Aust, F., Awtrey, E., … Nosek, B. A. (2015). Many analysts, one dataset: Making transparent how variations in analytical choices affect results. Open Science Framework, 1–56. [siehe https://osf.io/gvm2z/]

einen Datensatz an 29 verschiedene Forschergruppen gegeben und um Auswertung gebeten. Es ging darin um die durchaus spannende Frage, ob die Hautfarbe eines Fussballspielers Einfluss nimmt auf die Tendenz von Schiedsrichtern, rote Karten zu geben. Es kommen 29 verschiedene Ergebnisberichte zusammen, die einen weiten Range an Schlußfolgerungen abdecken und von signifikanten Einflüssen bis hin zu keinen Einflüssen reichen. Wohlgemerkt: es handelt sich um den gleichen Datensatz!

In Sachen Reproduzierbarkeit ist sicher noch nicht das letzte Wort gesprochen – in den Foren und Blogs wird heftig weiterdiskutiert, siehe z.B.:

- https://replicationindex.wordpress.com/2016/03/12/estimating-replicability-of-psychological-science-35-or-50/ und generell: https://replicationindex.wordpress.com/ Ulrich Schimmack ist einer der treiben Kräfte in dieser Debatte und hat mit seinem R-Index ein interessantes Hilfsmittel zur Bewertung bereitgestellt

- http://retractionwatch.com/2016/03/03/more-than-half-of-top-tier-economics-papers-are-replicable-study-finds/ auch andere Disziplinen machen sich ihre Gedanken – Retraction Watch ist generell empfehlenswert, wenn es um gute (oder schlechte) wissenschaftliche Praxis geht

- http://www.dgps.de/index.php?id=2000498&tx_ttnews[tt_news]=1630&cHash=6734f2c28f16dbab9de4871525b29a06 die DGPs-Stellungnahme war nicht unumstritten

- http://michaelinzlicht.com/getting-better/2016/2/29/reckoning-with-the-past hat die Baumeister-Arbeiten zu „Ego depletion“ überprüft und ist schwer schockiert

- http://deevybee.blogspot.de/2016/03/there-is-reproducibility-crisis-in.html Dorothee Bishops (Oxford) Blog

Wichtig scheint mir darüber nachzudenken, was eigentlich Replikation bedeuten soll und was eine „gute“ Replikation von einer „schlechten“ unterscheidet. Für mich ist das Konzept der „konzeptuellen“ Replikation (im Unterschied zur exakt gleichen) wichtig: zu sehen, ob selbst bei geänderter Spezifikation von Details ein Effekt erhalten bleibt. Beispiel: Bleibt die Ebbinghaus’sche Gedächtniskurve erhalten, wenn man andere sinnfreie Silben verwendet als der Original-Autor? [Antwort: ja!] Bleibt die Ebbinghaus’sche Gedächtniskurve erhalten, wenn man statt sinnfreien Silben bedeutungstragendes Wortmaterial verwendet? [Antwort: nein!]

An solchen „konzeptuellen“ Erweiterungen sieht man m.E. die Tragfähigkeit von Effekten deutlicher als an statistischen Signifikanzen, die knapp die willkürlich gezogene Zufallsgrenze unterschreiten. Aber wann ist eine Replikation eine „Replikation“?